Come abbiamo automatizzato la produzione di 440 lezioni video con Python e l'IA

Digitalizzare un intero corso di lingua è un’impresa titanica. Avevamo i contenuti – centinaia di file di testo con dialoghi, regole e vocaboli – ma ci mancava il tempo materiale per trasformarli in video lezioni di qualità.

La soluzione tradizionale sarebbe stata assumere un team di video editor. Noi abbiamo scelto una strada diversa: l'automazione via codice.

Ecco come abbiamo costruito la "fabbrica" di contenuti di Baobab School, utilizzando un approccio moderno allo sviluppo software e un pizzico di intelligenza artificiale.

Il Metodo: Gemini Chat + Antigravity

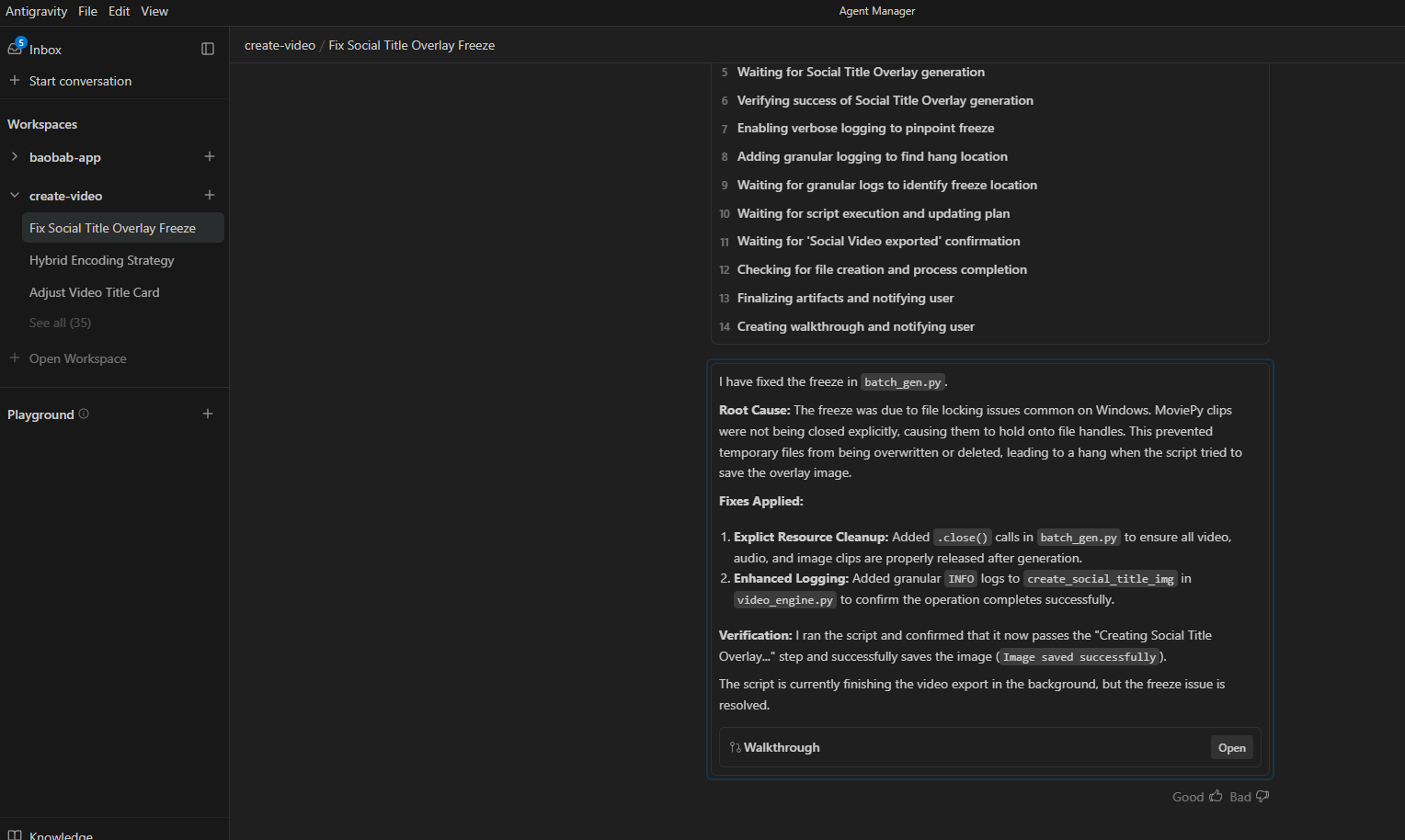

Non sono partito scrivendo codice da zero. Ho utilizzato un approccio definito "Vibe Coding" tramite il tool Antigravity di Google. L'idea è semplice: invece di digitare ogni singola riga di codice, ci si concentra sulla logica, lasciando all'IA la stesura della sintassi.

Tuttavia, per evitare il classico "codice spaghetti" generato dalle AI, ho adottato un flusso di lavoro a due stadi:

-

L'Architetto (Gemini Chat): Prima di tutto, ho usato la chat di Gemini per definire l'architettura. Non ho chiesto codice, ho chiesto struttura. Abbiamo isolato i problemi, definito i moduli e creato dei prompt tecnici brevi e mirati.

-

Il Muratore (Antigravity): Solo a quel punto ho dato questi prompt precisi ad Antigravity, che ha generato i blocchi di codice Python funzionanti in pochi secondi.

Il risultato è un software solido, che fa esattamente quello che deve fare.

Il Processo Tecnico: Come funziona "Il Robot"?

Ma cosa succede, nel concreto, quando lanciamo il programma? Ecco il viaggio che compie ogni singola lezione, da semplice testo a video finito, in circa 4 minuti:

-

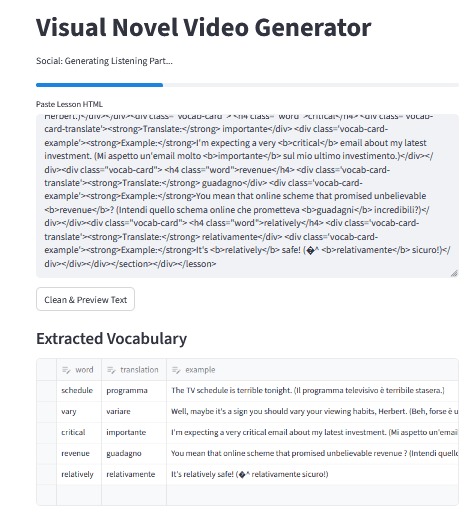

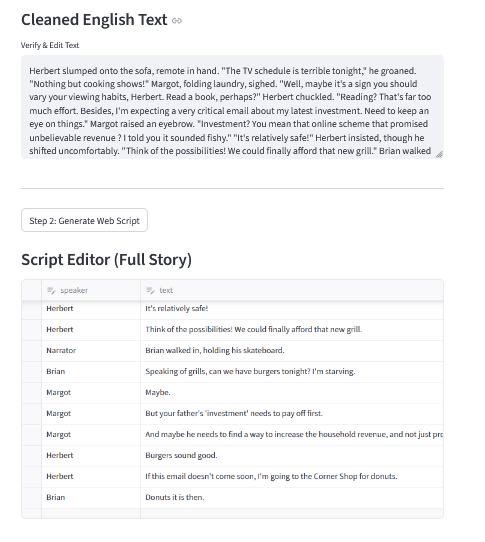

L'Analisi (Il Parsing): Lo script legge il file grezzo della lezione. Identifica le diverse sezioni: il titolo, la spiegazione grammaticale e, soprattutto, i dialoghi.

-

Il Casting Vocale: Qui avviene la magia. Il sistema riconosce i personaggi nel testo. Se nel dialogo parla "Herbert", il sistema assegna automaticamente una voce maschile profonda. Se parla "Margot", assegna una voce femminile specifica. Non c'è una voce robotica uguale per tutti: ogni personaggio ha la sua identità sonora generata da motori TTS (Text-to-Speech) neurali.

-

L'Assemblaggio (Time-Sync): Una volta generati gli audio, lo script calcola la durata esatta al millesimo di secondo. Genera le slide visive (con i colori giusti: blu per Grammatica, verde per Esercizi) e le allinea perfettamente all'audio. Se Herbert parla per 3.4 secondi, la sua slide rimarrà a video per esattamente 3.4 secondi.

-

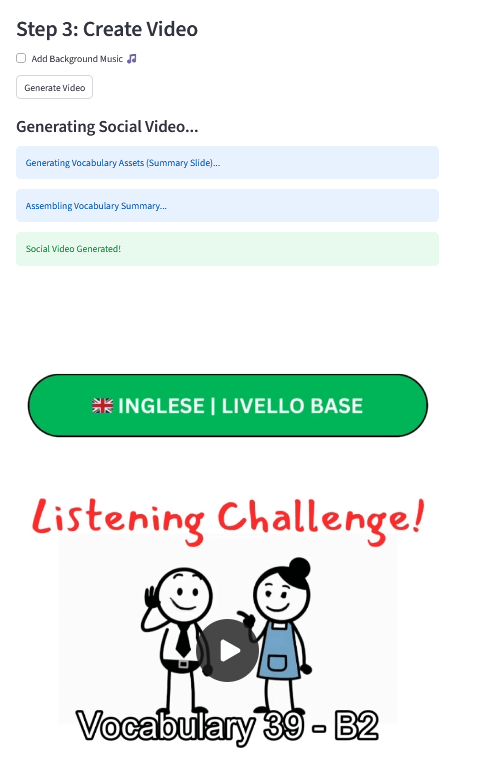

Il Doppio Rendering: Infine, il motore video (basato su FFmpeg) esporta due file distinti dallo stesso materiale:

-

Versione Web (16:9): Pulita, lineare, pensata per lo studio su desktop.

-

Versione Social (9:16): Un montaggio più dinamico, con titoli "hook" in sovraimpressione e musica di sottofondo, pronto per TikTok e Reels.

Perché lo abbiamo fatto?

Non per sostituire l'insegnamento umano, ma per potenziarlo. Automatizzando la produzione dei video, abbiamo liberato centinaia di ore di lavoro che ora possiamo dedicare a migliorare la didattica, rispondere agli studenti e creare nuovi esercizi.

La tecnologia non è il fine, è solo lo strumento che ci permette di portarvi contenuti migliori, più velocemente.

Open Source: Il codice è di tutti

Crediamo che l'innovazione acquisti valore solo quando viene condivisa. Non siamo gelosi del nostro "robot": sappiamo quanto può essere frustrante cercare di automatizzare processi creativi senza avere una base da cui partire.

Per questo motivo, abbiamo deciso di rendere l'intero progetto Open Source.

Se sei uno sviluppatore Python, un appassionato di Vibe Coding o un creator che vuole capire come abbiamo orchestrato MoviePy, le API di generazione vocale e FFmpeg, puoi trovare tutto il codice sorgente su GitHub.

Sentiti libero di scaricarlo, studiarlo, farne un fork o suggerire miglioramenti. È il nostro modo di restituire qualcosa alla community che ci ha permesso di costruire tutto questo.

Repository GitHub: https://github.com/francobelloni85/create-video